授業中に質問に答えてくれるティーチングアシスタントロボットの開発(ロボット・メカトロニクス学科/健康福祉支援開発センター 教授 吉野 和芳)

ロボット・メカトロニクス学科/健康福祉支援開発センター 吉野 和芳教授

パソコンやものづくりなどの実習授業中、授業の指導者をサポートし、学習者の質問に対応してアドバイスしてくれるティーチングアシスタントロボットを目指す。

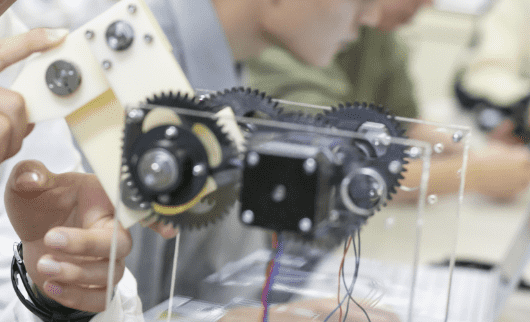

パソコンやものづくりなどの実習授業中では、学習者によって進み具合が異なるため、指導者は学習者からの質問に対応することが大変な作業になり、それにより,授業の進度に影響することも考えられます。そこで、そのような授業で指導者に代わって学習者の質問に対応し、アドバイスしてくれるティーチングアシスタントロボットに関して研究を行っています。この研究では、写真1のように、ソフトバンク社のPepperを利用し、授業中に質問のある学習者のところに行き、学習者との会話や状況を見ながら、学習者にアドバイスするということを目指しています。

【画像1】

このティーチングアシスタントロボットを実現するために必要な機能は、大きく3つに分けると、① 質問のある学習者の発見、② 質問の内容の理解、③ 質問へのアドバイスになります。

質問のある学習者の発見は、質問のあるとき挙手をしてもらうこととし、Pepperに搭載されているビデオカメラで教室内の状況を撮影し、その映像を処理することで、挙手している学習者を発見しています。具体的には、Pepperで撮影した映像内から、Pepperの方を向いている顔を検出し、その顔の上部付近に肌色領域があったら挙手していると判断しています。写真2は、顔の位置(四角枠)と挙手した手(丸印)を検出した結果を示しています。

【画像2】

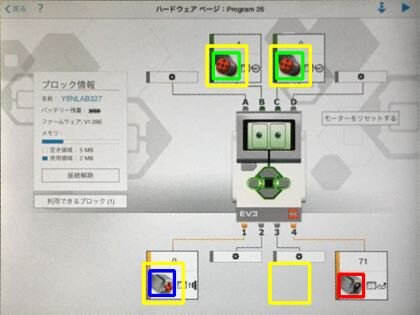

質問内容の理解とその質問へのアドバイスは、授業の進行に合わせ、質問者と会話しながら質問内容を音声認識により判断するとともに、アドバイスするために学習者の映像を処理して状況を判断することで実現しています。例えば、ロボットを組み立て、プログラミングしてロボットを動かすという実習授業を想定し、学習者から「ロボットが動かない」という質問があったとすると、ロボットが動かない原因として電源が入っていないなど、いくつか考えられますので、ティーチングアシスタントロボットは、それら考えられる原因を順に確認していく作業を行い、その原因が見つかったところで、学習者にアドバイスします。図3では、ロボットのモータやセンサの結線の状態を確認している例です。正しくは黄色の枠のところにモータ(緑枠)やタッチセンサ(青枠)、カラーセンサ(赤枠)があるはずなのに、赤枠が黄色枠以外の場所にあります。その状況からティーチングアシスタントロボットは学習者に対して「カラーセンサの結線が間違っています」というアドバイスを行うようにしています。

現在、私たちの研究室では、ティーチングアシスタントロボットに必要な基礎的な要素技術に関して検討し、作成しています。今後は、質問者のところへ移動していく、質問者の質問内容の認識精度を向上させる、アドバイスできる範囲を拡張することなどを進めていく予定です。

【図3】